Por Paulo Freitas

Ataques Adversariais na Camada Física

Este é o segundo post da nossa série “Ameaças aos sistemas baseados no aprendizado de máquinas”, na qual discutimos os riscos e vulnerabilidades introduzidos pelo uso de aprendizagem de máquina. Como apresentado em nosso post anterior, ataques adversariais introduzem perturbações imperceptíveis que comprometem os resultados dos modelos de aprendizagem de máquina e, portanto, potencialmente comprometem o funcionamento de sistemas que dependem deles, tais como sistemas de detecção de intrusão e sistemas de biometria facial [1], [2]. Neste post, discutimos como tais ataques afetam a camada física do modelo OSI e podem interromper a comunicação sem fio, do 5G por exemplo, concentrando-se em uma aplicação de classificação de modulação [3]. Nos posts seguintes, cobrimos ataques adversariais nas camadas de rede e aplicação do modelo OSI, e discutimos possíveis mecanismos de defesa contra ataques adversariais.

Aprendizagem de máquina em comunicação sem fio e classificação de modulação

Embora a maioria de nós esteja familiarizada com aplicações de aprendizagem de máquina relacionadas com a classificação de imagens, tais como reconhecimento facial e detecção de obstáculos, a aprendizagem de máquina também tem sido amplamente adotada em muitas outras áreas devido a sua poderosa capacidade de classificação. Entre elas, é particularmente útil para diversas aplicações de comunicação sem fio, tais como classificação de esquemas de modulação.

Na comunicação sem fio, os dispositivos comunicam-se entre si através da transmissão de ondas eletromagnéticas. Para transmitir sinais de dados em ondas eletromagnéticas, os transmissores sem fio, que estão embutidos em qualquer dispositivo sem fio, precisam modular os sinais, ou seja, codificá-los de uma maneira particular que permita a sua transmissão. Da mesma forma, os receptores sem fio, que também estão embutidos em dispositivos sem fio, demodulam os sinais, ou seja, decodificam os dados recebidos para eles que possam ser compreendidos e utilizados. Embora existam muitos esquemas de modulação diferentes, os sinais devem ser sempre modulados e demodulados usando o mesmo esquema de modulação, pois a demodulação deve desfazer a operação de modulação [4], [5]. De maneira semelhante, imagine que a operação de modulação corresponde a uma pessoa falando em inglês. Sua audiência, ou seja, as pessoas que recebem a mensagem falada também devem falar em inglês, caso contrário não serão capazes de entender a mensagem transmitida. A Figura 1 mostra um sinal antes de ser modulado, depois de sua modulação e depois de sua demodulação.

O classificador de modulação VT-CNN2

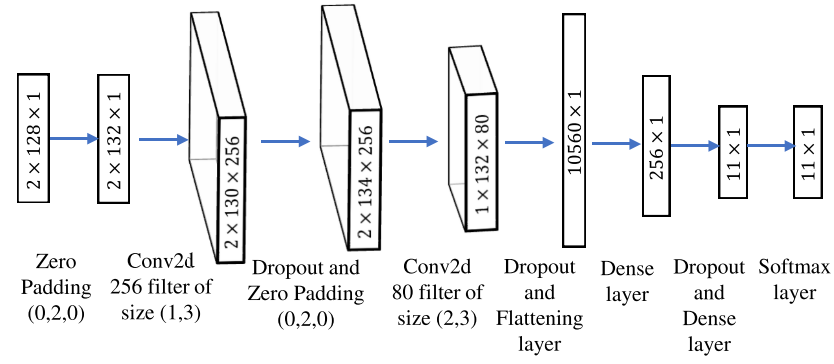

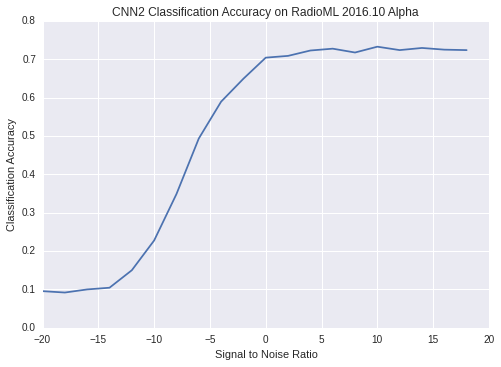

O classificador de modulação VT-CNN2, proposto em [4], [5] é um dos classificadores mais utilizados pelos trabalhos que lidam com problemas de classificação de modulação. Ele se baseia em redes neurais convolucionais profundas e classifica sinais modulados entre onze diferentes esquemas de modulação. Ou seja, dada uma amostra do sinal transmitido, ele identifica qual esquema de modulação foi usado dentre onze diferentes esquemas possíveis. As Figuras 2 e 3 mostram a arquitetura da rede neural VT-CNN2 e os seus resultados da classificação, respectivamente. A relação sinal ruído (SNR) representada na Figura 3 se refere a quantidade de ruído no sinal, tal que sinais com altos SNRs não possuem muito ruído e sinais com baixos SNRs possuem mais ruído.

Comprometendo classificadores de modulação com ataques adversariais

Como discutido em nosso post anterior, os modelos de aprendizagem de máquina têm demonstrado ser vulneráveis a ataques adversariais. Ataques adversariais introduzem perturbações imperceptíveis especialmente construídas para forçar resultados errados de classificação [7]-[9]. Assim, eles podem induzir os classificadores de modulação a identificar erroneamente o esquema de modulação utilizado para que um sinal não seja corretamente demodulado e a comunicação seja comprometida. Assim, apesar dos bons resultados, a utilização de classificadores de modulação baseados em aprendizagem da máquina, como o VT-CNN2, coloca em dúvida a segurança e confiabilidade dos sistemas de comunicação sem fio [8].

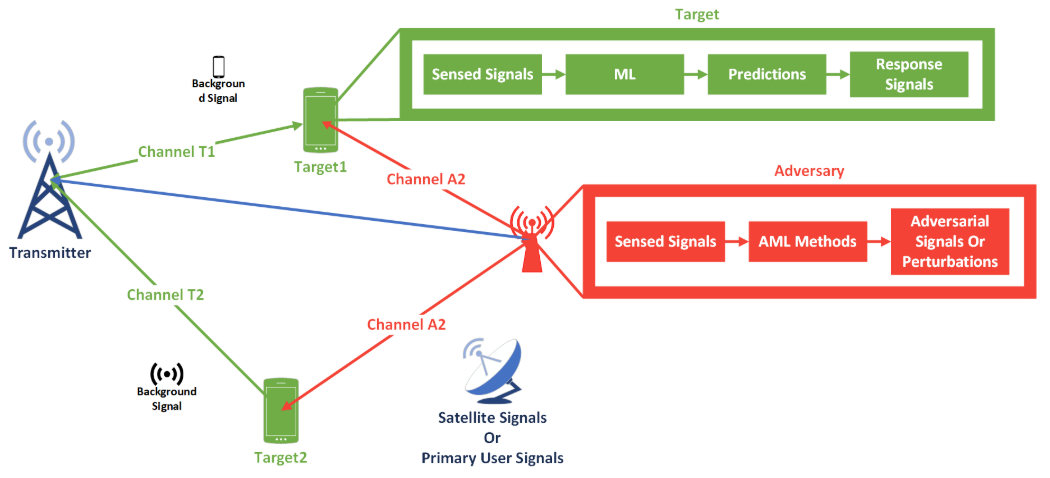

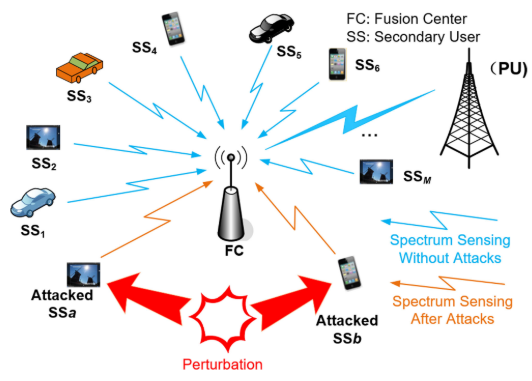

A natureza compartilhada e broadcast da comunicação sem fio permite que atacantes adulterem os sinais que são transmitidos por vias aéreas. Assim, ataques a classificadores de modulação podem ser lançados a partir de transmissores maliciosos, ou por transmissores e receptores legítimos que foram infectados e comprometidos por malwares [8]. A Figura 4 ilustra um atacante que transmite perturbações adversariais a partir de um transmissor malicioso. A Figura 5 ilustra que essas interferências podem afetar vários dispositivos conectados, incluindo modelos de aprendizagem de máquina que funcionam em veículos e telefones celulares.

Técnica Multi-Objective GAN-Based Adversarial Attack

Como ataques adversariais podem comprometer a operação dos receptores sem fio, pesquisas têm explorado e avaliado este problema. O trabalho em [8], por exemplo, propõe uma técnica de ataque adversarial que reduz significativamente a acurácia de classificadores de modulação. Ele cria perturbações adversariais e às acrescenta a amostras de dados recebidas pelos receptores sem fio pelo menos 335 vezes mais rápido do que outras técnicas avaliadas, o que levanta sérias preocupações sobre o uso de classificadores de modulação baseados em aprendizagem de máquina.

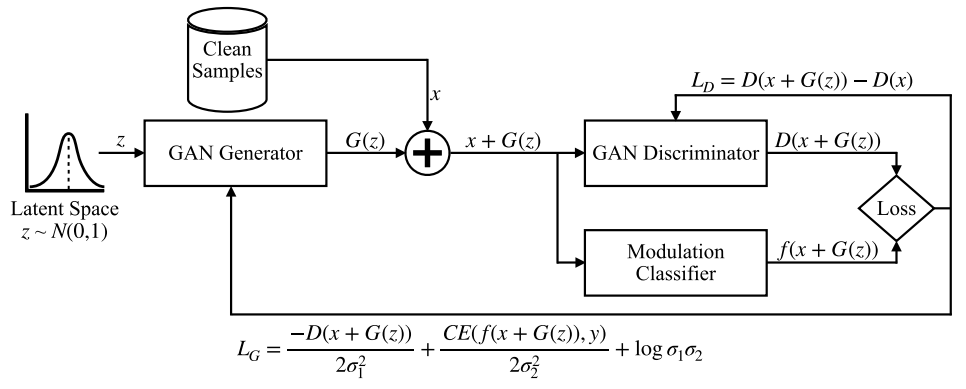

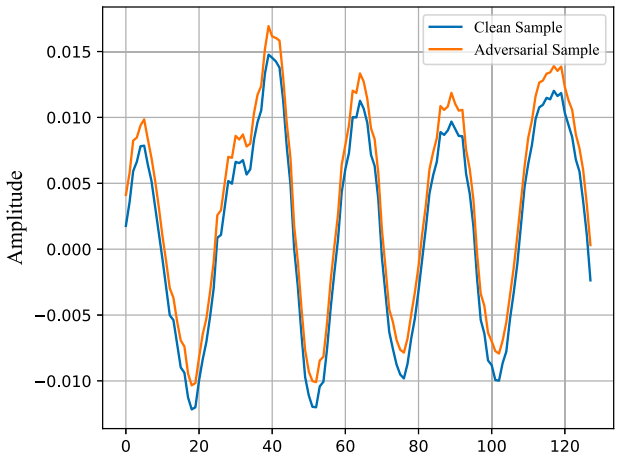

O trabalho em [8] considera que um receptor sem fio foi comprometido por malware e que o ataque adversarial proposto foi lançado diretamente sobre esse receptor. Esse ataque utiliza redes adversariais generativas (GANs), que é uma estrutura de aprendizagem profunda que treina duas redes neurais concorrentes: gerador e discriminador [8]. O gerador aprende a produzir amostras que são similares às de um conjunto de treinamento. O discriminador, por sua vez, aprende a distinguir entre as amostras reais e as amostras que foram produzidas pelo gerador. Os autores de [8] modificaram a estrutura da GAN para que o gerador produzisse perturbações adversariais que foram então utilizadas para adulterar as amostras recebidas pelo receptor sem fio. A Figura 6 mostra a arquitetura da GAN proposta em [8]. A Figura 7 ilustra a versão limpa e adulterada de uma amostra recebida à qual foi adicionada uma perturbação adversarial. Como as amostras adversariais não devem ser facilmente reconhecidas, observe que as amostras limpas e adversariais mostradas na Figura 7 são muito semelhantes entre si.

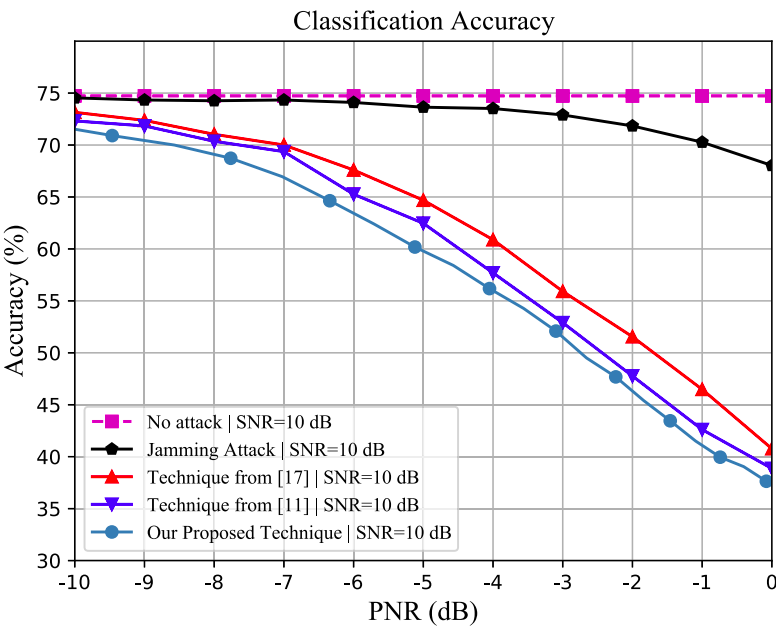

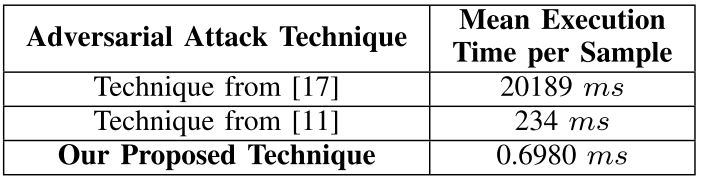

O trabalho em [8] avaliou sua proposta de ataque adversarial sobre o classificador de modulação VT-CNN2. Assim, a Figura 8 mostra a precisão do VT-CNN2 em amostras limpas e em amostras adversariais produzidas pela técnica proposta em [8], duas outras técnicas de ataques adversariais, e um ataque de jamming, que introduz um ruído aleatório nas amostras recebidas. Finalmente, a Figura 9 mostra o tempo médio que cada técnica avaliada leva para a produzir e adicionar perturbações adversariais nas amostras recebidas. A técnica proposta em [8] supera significativamente as outras duas técnicas de ataques adversariais avaliadas, produzindo perturbações adversariais em menos de 0,7 ms.

Conclusão

Neste post, discutimos como ataques adversariais podem comprometer os classificadores de modulação e potencialmente interromper a comunicação sem fio. Conforme demonstrado, os ataques representam uma grande ameaça cujo impacto vai muito além das aplicações de classificação de imagem. Portanto, é urgente e necessário melhorar os sistemas baseados em aprendizagem de máquina para torná-los resistentes a este tipo de ataque. Além disso, como a maioria dos trabalhos sobre ataques adversariais se concentra na classificação de imagens, ainda é necessário realizar mais pesquisas a fim de entender melhor os impactos das ameaças em outras áreas, como em ciber-segurança. Na Tempest, estamos cientes de tais riscos e estamos desenvolvendo técnicas de defesa para melhor proteger seu negócio! Fique atento aos nossos próximos posts!

Referências

[1] A. Chakraborty, M. Alam, V. Dey, A. Chattopadhyay, and D. Mukhopadhyay. Adversarial Attacks and Defences: A survey. arXiv preprint arXiv:1810.00069, 2018.

[2] J. Liu, M. Nogueira, J. Fernandes and B. Kantarci, “Adversarial Machine Learning: A Multilayer Review of the State-of-the-Art and Challenges for Wireless and Mobile Systems,” in IEEE Communications Surveys & Tutorials, vol. 24, no. 1, pg. 123-159, Firstquarter 2022, doi: 10.1109/COMST.2021.3136132.

[3] B. Flowers, R. M. Buehrer and W. C. Headley, “Evaluating Adversarial Evasion Attacks in the Context of Wireless Communications,” in IEEE Transactions on Information Forensics and Security, vol. 15, pp. 1102-1113, 2020, doi: 10.1109/TIFS.2019.2934069.

[4] T. J. O’Shea, J. Corgan, and T. C. Clancy, “Convolutional radio modulation recognition networks,” in Proc. Int. Conf. Eng. Appl. Neural Netw. Aberdeen, U.K., Springer, 2016, pg. 213–226.

[5] T. J. O’Shea, T. Roy, and T. C. Clancy, “Over-the-air deep learning based radio signal classification,” IEEE J. Sel. Topics Signal Process., vol. 12, no. 1, pg. 168–179, Fevereiro. 2018.

[6] PadaKuu, “AM Modulation/Demodulation”. Accessed: Aug. 30, 2022. [Online]. Disponível: https://padakuu.com/articles/images/cover/cover-170826052205.jpg

[7] Y. Lin, H. Zhao, X. Ma, Y. Tu, and M. Wang, “Adversarial attacks in modulation recognition with convolutional neural networks,” IEEE Trans. Rel., vol. 70, no. 1, pg. 389–401, Mar. 2021.

[8] P. Freitas de Araujo-Filho, G. Kaddoum, M. Naili, E. T. Fapi and Z. Zhu, “Multi-Objective GAN-Based Adversarial Attack Technique for Modulation Classifiers,” in IEEE Communications Letters, vol. 26, no. 7, pg. 1583-1587, Julho 2022, doi: 10.1109/LCOMM.2022.3167368.

[9] M. Sadeghi and E. G. Larsson, “Adversarial Attacks on Deep-Learning Based Radio Signal Classification,” in IEEE Wireless Communications Letters, vol. 8, no. 1, pg. 213-216, Fevereiro. 2019, doi: 10.1109/LWC.2018.2867459.

[10] T. O’Shea, “Modulation Recognition Example: RML2016.10a Dataset + VT-CNN2 Mod-Rec Network”. Accessed: Aug. 30, 2022. [Online]. Disponível: https://github.com/radioML/examples/blob/master/modulation_recognition/RML2016.10a_VTCNN2_example.ipynb